ابزار web scraping، برای توسعه دهندگان و با هدف استخراج اطلاعات از وبسایتها ساخته شدهاند. این ابزار همچنین تحت عنوان ابزار درو کردن یا ابزار استخراج دادههای وب هم شناخته میشوند. این ابزارها برای هر کسی که در تلاش است تا نوعی داده را از اینترنت جمعآوری کند، کاربردی هستند. web scraping، تکنیک ورودی داده جدید است و نیازی به تایپ کردن یا کپی و پیست کردن تکراری ندارد.

این نرمافزارها به صورت دستی یا خودکار به دنبال دادهها میگردند، دادههای جدید و بروزرسانی شده را میگیرند و آنها را برای دسترسی آسان شما ذخیره میکنند. برای مثال شاید شخصی اطلاعات درباره محصولات و قیمت آنها را با استفاده از یک ابزار web scraping، از Amazon جمعآوری کند. در این پست، ما موارد استفاده از ابزار web scraping و ۱۰ مورد از برترینهای آنها را برای جمعآوری اطلاعات، بدون ذرهای کدنویسی لیست میکنیم.

چرا ابزار web scraping؟

ابزار web scraping میتوانند برای اهداف بی نهایتی در سناریوهای مختلف استفاده شوند، اما ما میخواهیم موارد استفاده رایج که برای کاربران عمومی در دسترس هستند را مورد بررسی قرار دهیم.

۱. جمعآوری دادهها برای تحقیقات بازاری

ابزار web scraping میتوانند شما را درباره این که شرکت شما در شش ماه بعدی به کجا میرود، مطلع نگه دارند و به عنوان ابزار قدرتمندی برای تحقیقات بازاری عمل کنند. این ابزار میتوانند دادهها را از چندین فراهم کننده اطلاعات تجزیه و تحلیلی بگیرند، و آنها را برای ارجاع و تجزیه و تحلیل راحتتر در یک مکان جمع کنند.

۲. استخراج اطلاعات تماس

این ابزار همچنین میتوانند برای استخراج دادههایی مانند آدرس ایمیل و شماره تلفن از وبسایتهای مختلف استفاده شده، و داشتن لیستی از فراهم کنندگان، تولید کنندگان و افراد دیگر مد نظر شما را ممکن سازند.

۳. دانلود کردن راه حلها از StackOverFlow

هر شخصی با استفاده از یک ابزار web scraping میتواند راه حلها را با جمعآوری از چندین وبسایت (شامل StackOverflow و وبسایتهای دیگر) برای خواندن آفلاین یا ذخیرهسازی دانلود کند. این کار وابستگی به ارتباطات اینترنت فعال را کاهش میدهد؛ زیرا منابع مورد نظر اعم از دسترسیپذیری اینترنت، آماده هستند.

۴. گشتن برای مشاغل یا کاندیداها

برای افرادی که به طور فعالانه به دنبال نامزدهایی برای پیوستن به تیمشان هستند، یا افراد جویای شغلی که به دنبال یک نقش یا شغل خاص میباشند، این ابزار برای دریافت دادهها بر حسب فیلترهای مختلف اعمال شده، و بدون جستجوی دستی به خوبی کار میکنند.

۵. ردگیری قیمتهای چند بازار

اگر به خرید آنلاین و ردگیری فعالانه قیمت محصولاتی که به دنبالشان هستید علاقه دارید، پس قطعا به یک ابزار web scraping نیازمندید.

بهترین ابزار web scraping

بیایید نگاهی به ۱۰ مورد از برترین ابزار web scraping در دسترس داشته باشیم. برخی از آنها رایگان هستند، برخی دوره آزمایشی دارند و برخی هم باید خریداری شوند. قبل از این که به سراغ هر کدام بروید، جزئیات آنها را بخوانید.

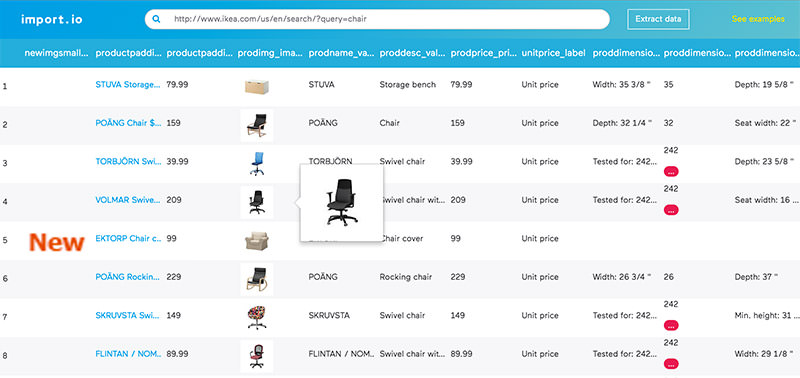

Import.io

Import.io یک سازنده را برای تشکیل دیتابیس خود، با به سادگی وارد کردن دادهها از یک صفحه وب مشخص و خروجی گرفتن آنها در قالب CSV ارائه میدهد. شما میتوانید به آسانی هزاران صفحه وب را در چند دقیقه و بدون نوشتن یک خط کد بخراشید، و بیش از هزار API را بر پایه نیازمندیهای خود بسازید.

Import.io همه روزه از فناوریهای جدیدی برای دریافت میلیونها داده استفاده میکند، که کسب و کارها میتوانند از آن با هزینه کمی بهره ببرند. Import.io به همراه ابزار وب، همچنین برنامههای رایگانی را برای ویندوز، Mac OS X و لینوکس ارائه میدهد تا استخراج کنندههای داده را ساخته، دادهها را دانلود کرده و با حسابهای آنلاین همگامسازی کند.

Webhose.io

Webhose.io دسترسی مستقیم را به دادههای real-time و ساختاربندی شده از هزاران منبع آنلاین فراهم میکند. این خراش کننده وب از استخراج دادههای وب در بیش از ۲۴۰ زبان و ذخیره کردن دادههای خروجی در قالبهای مختلفی مانند XML، JSON و RSS پشتیبانی میکند.

Webhose.io یک وباپلیکیشن بر پایه مرورگر است که از فناوریهای داده خاصی برای کشیدن مقدار زیادی داده از چندین کانال، در تنها یک API استفاده میکند. این ابزار برای ۱۰۰۰ درخواست در ماه رایگان است و با پرداخت ۵۰ دلار، این مقدار به ۵۰۰۰ درخواست در ماه افزایش مییابد.

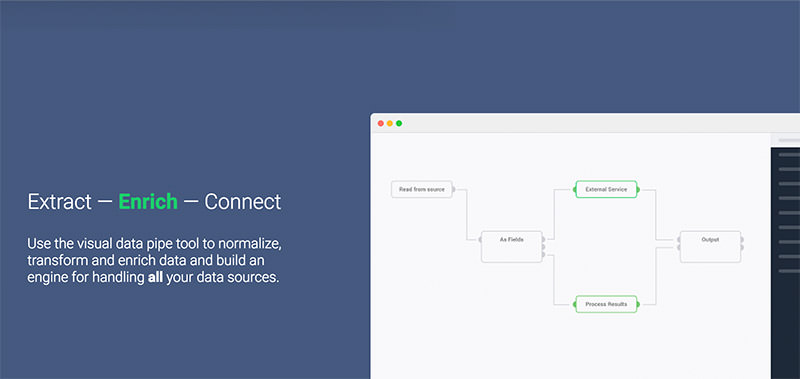

Dexi.io

(پیشتر با عنوان CloudScrape شناخته میشد)

CloudScrape جمعآوری دادهها از هر وبسایتی را پشتیبانی میکند و به مانند Webhose نیاز به هیچگونه دانلودی ندارد. این ابزار یک ویرایشگر بر پایه مرورگر را برای راهاندازی خزندهها و استخراج دادهها به صورت real-time فراهم میکند. شما میتوانید دادههای جمعآوری شده را بر روی پلتفرمهای ابری مانند Google Drive و Box.net ذخیره کنید، یا به عنوان CSV یا JSON خروجی بگیرید.

CloudScrape همچنین از دسترسی ناشناس به داده، با ارائه دادن مجموعهای از سرورهای پروکسی برای مخفی کردن هویت شما پشتیبانی میکند. CloudScrape دادههای شما را قبل از بایگانی کردن، به مدت ۲ هفته بر روی سرورهای خود ذخیره میکند. این ابزار web scraping ۲۰ ساعت scraping را به صورت رایگان ارائه میدهد، و ماهانه ۲۹ دلار هزینه خواهد داشت.

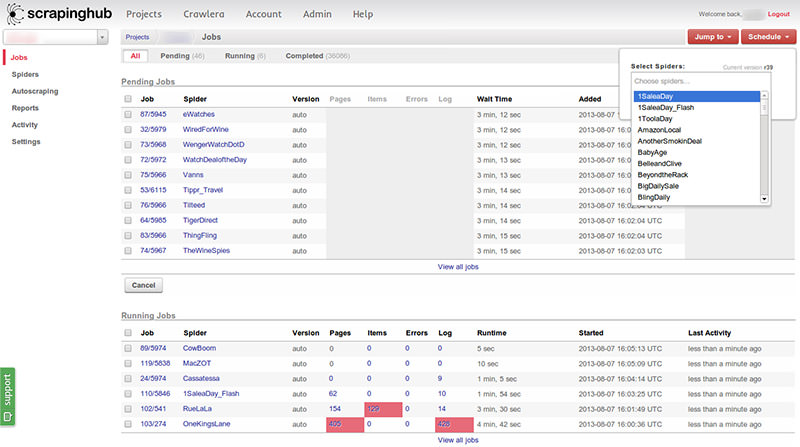

Scrapinghub

Scrapinghub یک ابزار استخراج داده ابری است که به هزاران توسعه دهنده در دریافت دادههای با ارزش کمک میکند. Scrapinghub از Crawlera، یک چرخنده پروکسی هوشمند استفاده میکند.

Springhub کل صفحه وب را به محتویات سازماندهی شده تبدیل میکند. اگر خزیدن آن به درستی کار نکند، تیم متخصصان آن برای کمک به شما در این زمینه در دسترس هستند. نسخه رایگان آن امکان تنها ۱ خزیدن را به شما داده، و نسخه خریدنی آن به قیمت ۲۵ دلار در ماه دسترسی به ۴ خزیدن موازی را به شما میدهد.

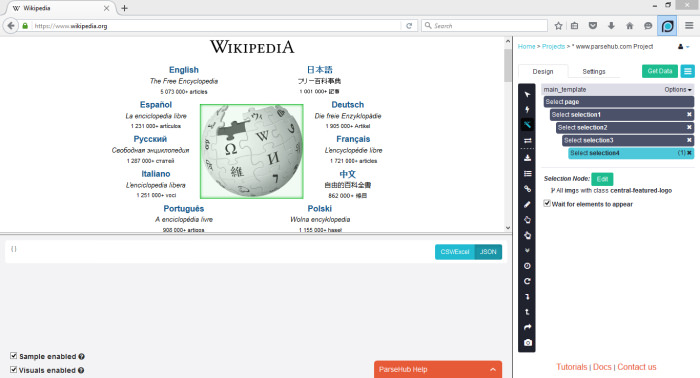

ParseHub

ParseHub ساخته شده است تا وبسایتهای تنها و چندگانه را با پشتیبانی از JavaScript، AJAX، sessionها و کوکیها بخزد. این برنامه از فناوری یادگیری ماشین برای تشخیص تطبیق پذیرترین سند بر روی وب استفاده کرده و فایل خروجی را بر پایه قالب داده مورد نیاز تولید میکند.

ParseHub جدا از وباپلیکیشن خود بر روی دسکتاپ هم در دسترس است و تا ۵ پروژه را به صورت رایگان ارائه میدهد. این وبسایت به ازای ۸۹ دلار در ماه، پشتیبانی ۲۰ پروژه و ۱۰ هزار صفحه برای هر خزیدن را ارائه میدهد.

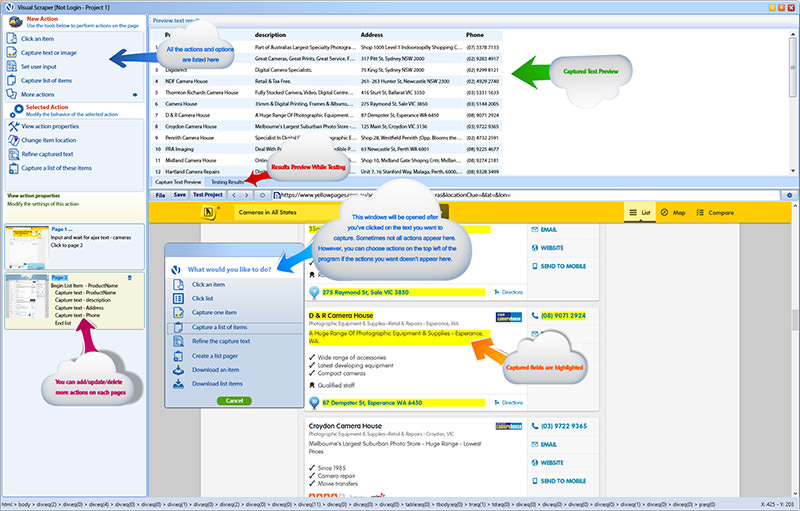

VisualScraper

VisualScraper یک نرمافزار استخراج داده وب دیگر است که میتواند برای جمعآوری اطلاعات بر روی وب استفاده شود. این نرمافزار در استخراج دادهها از چندین صفحه وب کمک کرده و نتایج را به صورت real-time دریافت میکند. به علاوه، شما میتوانید دادههای مذکور را در قالبهای مختلفی مانند CSV، XML، JSON و SQL خروجی بگیرید. شما میتوانید به آسانی دادههای وب را در رابط کاربری ساده آن جمعآوری کرده و مدیریت نمایید.

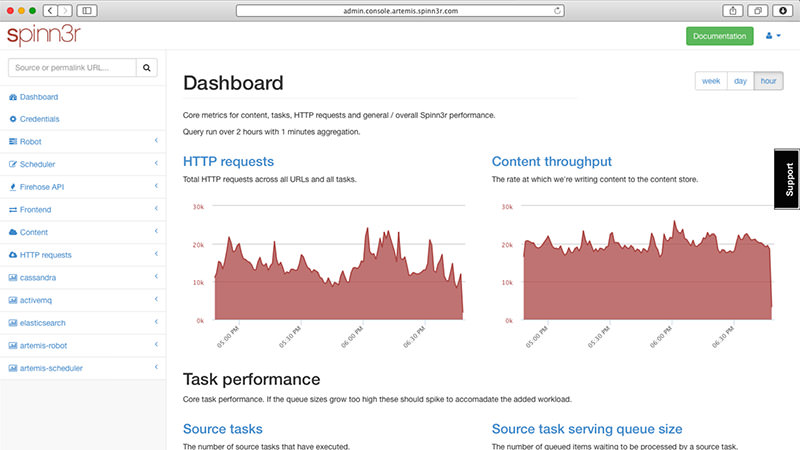

Spinn3r

Spinn3r شما را قادر میسازد تا کل دادهها را از وبلاگها، شبکههای اجتماعی، RSS و... جمعآوری کنید. Spinn3r با یک اِیپیآی firehouse توزیع شده است که ۹۵ درصد کارها را انجام میدهد. این ابزار یک حفاظت پیشرفته در مقابل اسپم را ارائه میدهد، که اسپمها و پیغامهای بد را حذف کرده و از این رو امنیت را بهبود میبخشد.

Spinn3r محتویات مشابه به گوگل را ورودی گرفته، و دادههای استخراج شده را در فایلهای JSON ذخیره میکند. این ابزار web scraping به طور مداوم وب را اسکن کرده و بروزرسانیها را از چندین منبع پیدا میکند. کنسول مدیر آن شما را قادر میسازد تا خزیدنها را کنترل کرده و جستجوی کامل متنی آن، کوئریهای پیچیده را بر روی دادههای خام ممکن میسازد.

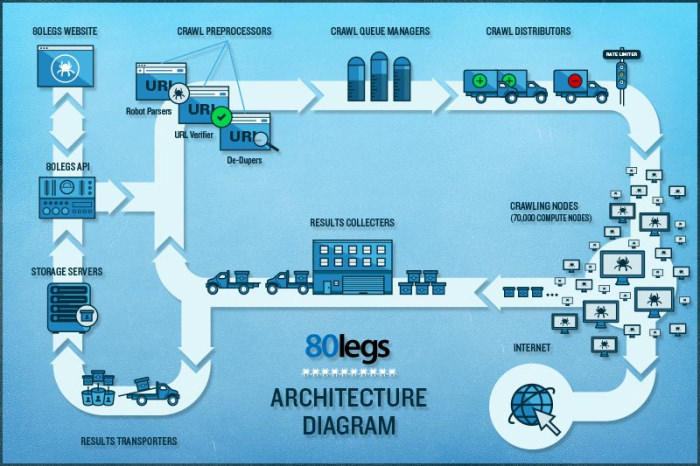

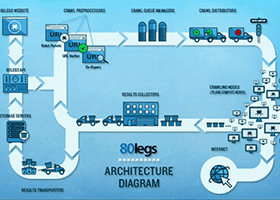

80legs

80legs یک ابزار web scraping قدرتمند، ولی منعطف است که میتواند برای نیازهای شما پیکربندی شود. این ابزار از دریافت حجم زیادی داده به همراه گزینههایی برای دانلود لحظهای دادههای استخراج شده پشتیبانی میکند. این ابزار web scraping ادعا میکند که ۶۰۰ هزار دامنه را خزیده است و مورد استفاده شرکتهای بزرگی مانند MailChimp و PayPal میباشد.

ویژگی «Datafiniti» آن قابلیت جستجوی سریع را به شما میدهد. 80legs یک web scraping با کارایی بالا را فراهم میکند که به سرعت کار کرده، و دادههای مورد نیاز را در عرض چند ثانیه دریافت میکند. این ابزار برای ۱۰ هزار URL رایگان بوده، و میتواند به ازای ۲۹ دلار در ماه به ۱۰۰ هزار URL ارتقا یابد.

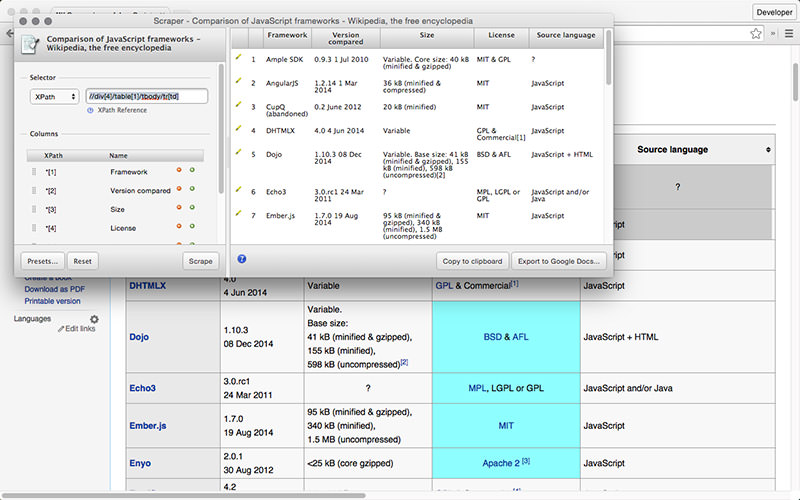

Scraper

Scraper یک افزونه Chrome با ویژگیهای استخراج داده محدود میباشد، اما برای انجام جستجوهای آنلاین، و خروجی گیری دادهها در قالب spreadsheetهای گوگل کاربردی است. این ابزار، تازهکاران و همچنین افراد حرفهای که میتوانند دادهها را به آسانی کپی کرده و با استفاده از OAuth ذخیره کنند را در هدف دارد.

Scraper یک ابزار رایگان میباشد که مستقیما در مرورگر شما کار میکند و XPathهای کوچکتر را به طور خودکار ایجاد میکند، اما همچنین برای تازه کاران هم خوب است؛ زیرا نیازی به پیکربندیهای پیچیده ندارد.

کدام مورد ابزار یا افزونه مورد علاقه شماست؟ شما چه نوع دادههایی را میخواهید از روی اینترنت استخراج کنید؟ داستان خود را در بخش نظرات با ما به اشتراک بگذارید.

در حال دریافت نظرات از سرور، لطفا منتظر بمانید

در حال دریافت نظرات از سرور، لطفا منتظر بمانید