Web scraping نامی آشنا در دنیای برنامهنویسی و تجارت آنلاین است. قدمت Web scraping با خود وب برابری میکند. اسکرپینگ به شما این امکان را میدهد تا چندین منبع داده را در یک مکان جمعآوری کنید. با این روش میتوانید پرسشهای داده خود را انجام داده و اطلاعات را به شکل دلخواه نمایش دهید.

من به چشم دیدهام که از وب اسکرپرها برای ساخت وبسایتهای محصول خودکار، دایرکتوریهای مقالات و پروژهها استفاده میشود که تعاملات بسیاری با دادهها دارند. این موارد چه تشابهی با یکدیگر دارند؟ شخصی که به دنبال وب اسکرپرهاست، به فکر پول نیز میباشد.

چه کاربردهای رایج دیگری برای استفاده از وب اسکرپرها وجود دارد؟ فکر کردن در مورد این موضوع برای من خندهدار است زیرا اولین چیزی که هنگام فکر کردن در مورد سایر کاربردهای اسکرپرها به ذهنم میرسد، توئیتی است که اوایل امسال توسط مت کاتس یکی از اعضای تیم اسپم گوگل فرستاده شده بود.

مت به طرفداران توئیتر خود گفت:« اگر یک URL اسکرپر را مشاهده کردید که سبب کاهش رتبه منبع اصلی محتوا در گوگل میشود، لطفاً این موضوع را به ما اطلاع دهید.» چند لحظه بعد دَن بارکر که یک کارآفرین آنلاین است، پاسخ جالبی داد تا نشان دهد مشکل واقعی گوگل چیست:

۳۰ هزار نفر این جمله را ریتوئیت کردند و به نظر من هم خیلی خندهدار بود. چیزی که باید در اینجا یاد گرفت این است که بدانید Web scraping در اطراف ماست. به عنوان مثال، وبسایتِ مقایسه قیمتی را تصور کنید که برای چک کردن مجدد درخواستهای جدید خود به مجموعهای جداگانه از کارمندان نیاز داشته باشد. مطمئناً این یک کابوس خواهد بود.

Web scraping دارای جنبههای مختلفی است و مطمئناً استفادههای گوناگونی نیز خواهد داشت. در اینجا چند مثال را بیان میکنم تا به شما بفهمانم که Web scraping فقط در مورد دزدیدن داده از دیگران نیست.

مقایسه قیمت

توانایی مقایسه قیمتها و دادهها به روشی کارآمدتر، یکی از کاربردهای عالی در اسکرپینگ است. به جای اینکه خودتان به صورت دستی قیمتها را بررسی کنید، میتوانید از یک اسکرپر برای انجام این کار و رسیدگی به درخواستها استفاده کنید.

جزئیات تماس

شما میتوانید این نوع اسکرپینگ را به صورت یک عملکرد مرزی در نظر بگیرید. با استفاده از یک وب اسکرپر امکان استخراج جزئیات افراد مانند نام، ایمیل، شماره و غیره وجود دارد.

تحلیل اجتماعی

فکر میکنم این مورد کمتر از آنچه که شایسته آن است مورد توجه قرار میگیرد. با توجه به تکنولوژیهای مدرن امروزی میتوانیم به راحتی وارد زندگی دیگران شویم. ما میتوانیم با اسکرپینگ کردن سایتهای اجتماعی مانند توئیتر یا فیسبوک به این نتیجه برسیم که گروههای مختلفی از مردم به چه چیزهایی علاقه دارند.

دادههای تحقیقاتی

همینطور که قبلاً بیان کردم، میتوانید مقادیر زیادی از داده را در یک مکان جمع کرده و سپس از آن به عنوان یک دیتابیس عمومی برای ساخت وبسایتهای اطلاعاتی یا محصولاتی شگفتانگیز استفاده کرد.

جاستین آبراهامز گفته است:« برخی از مردم محتوای یک وبسایت را اسکرپ کرده و آن را با نام خود در وبسایت منتشر میکنند. این کار هیچ فرقی با دزدی ندارد. انجام این کار به همان دلیلی اشتباه است که شما نمیتوانید اسم خود را بر روی کتاب نویسندهی دیگری ثبت کنید. قوانین مربوط به مالکیت، کپی رایت و علائم تجاری همچنان در اینترنت اعمال میشوند و مراجع قانونی آن هیچ فرقی نخواهد داشت.»

به عنوان مثال مدیر یک وبسایت از این موضوع بسیار ناامید شده است، زیرا یک شرکت دادههای او را دزدیده و اکنون در حال بدست آوردن سودی خیلی زیادی از آن است. بدترین قسمت این ماجرا چیست؟ در بسیاری از مواقع اثبات کردن این موضوع که آنها در حال استفاده از دادههای شما هستند، تقریباً غیرممکن میباشد.

خب این مقدمهی ابتدایی من در خصوص Web scraping است و آخرین نصیحت به شما یادگیری پایتون است. پایتون یکی از رایجترین زبانهای برنامهنویسی بوده که برای اسکرپینگ، استخراج و سازماندهی دادهها مورد استفاده قرار میگیرد. خوشبختانه یاد گرفتن این زبان نیز بسیار آسان است و روند یادگیری با استفاده از فریمورکهای مختلف سریعتر خواهد بود.

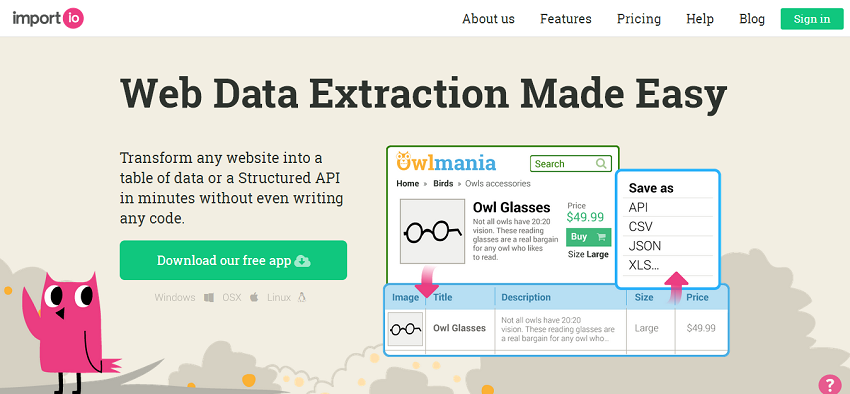

۱. Import.IO

اگرچه کمی گران است، اما من واقعاً عاشق کاری هستم که آنها در Import.IO انجام میدهند. شرکتهایی که به دنبال انعطاف پذیری بیشتر و دسترسی الگوریتمی هستند، میتوانند با تیم فروش تماس بگیرند. البته شما میتوانید برای همیشه از نسخه رایگان این ابزار نیز لذت ببرید.

ابزار اسکرپینگ وب آنها برای تمام سیستم عاملها در دسترس بوده و به مجموعهای از ویژگیهای شگفت انگیز مجهز است. من واقعاً به APIهای احزار هویت، مجموعه دادهها و فضای ذخیرهسازی ابری علاقه دارم. اما جواهر واقعی خود وبسایت آنهاست که در آن میتوانید بازخوردهای کاربران، دورههای آموزشی و راهنماهای بسیاری را پیدا کنید.

طبق تجربهای که در گذشته داشتم، فهمیدم که اسکرپینگ وبسایتی مثل ThemeForest بسیار آسان است و به همین خاطر پس از مدتی از این خسته شدم و دیگر به دنبال قابلیتهای آن نرفتم. من واقعاً دوست دارم نظر شما را در مورد Import بدانم. به نظر شما میتوان آن را یکی از بهترین ابزارهای رایگان در زمینه اسکرپینگ دانست؟

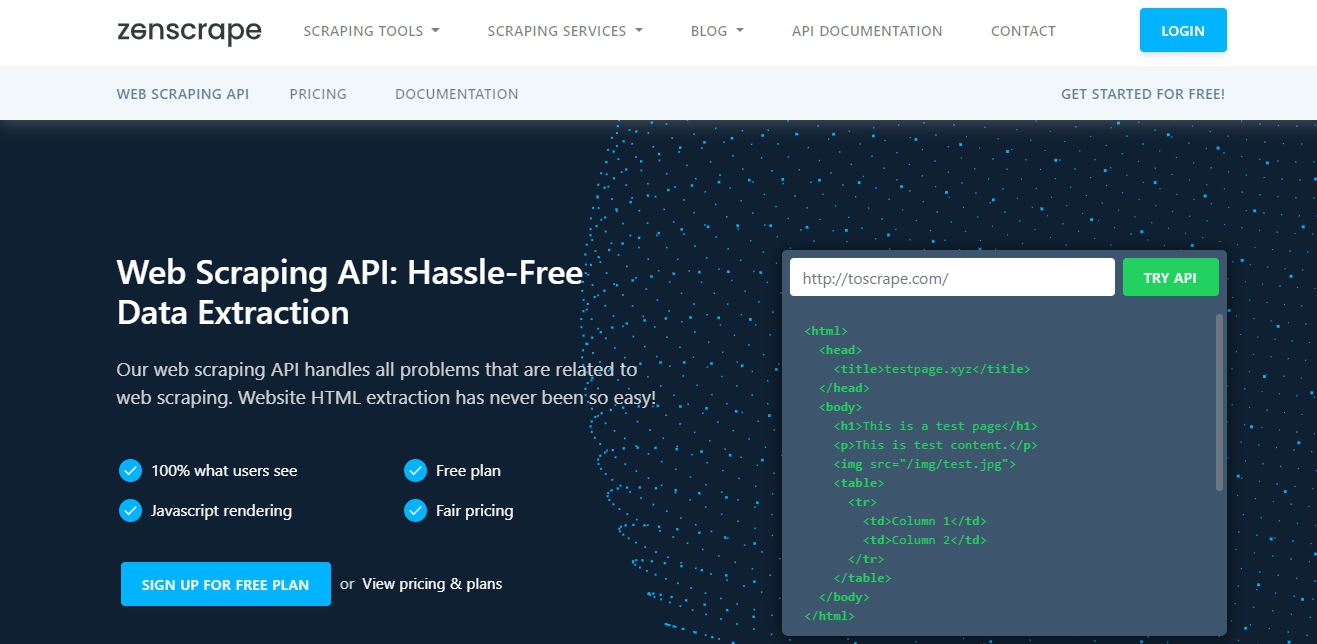

۲. Zenscrape

این یکی از ابزارهای جدید در Web scraping API بوده که به خاطر سهولت در استخراج داده محبوب شده است. در واقع این یک ابزار کاملاً جالب است که تمام مشکلات مربوط به Web scraping را همراه با استخراج HTML کنترل میکند. این ابزار یک API سریع میباشد، استفاده از آن آسان است و عملکرد فوقالعادهای دارد.

این ابزار به شما اجازه میدهد:

- هر وبسایتی را جستجو کنید

- قیمت و اطلاعات محصول را کنترل کنید

- یک استراتژی قیمتگذاری و سرمایهگذاری کاملاً اتومات بسازید

- پلتفرمهای نظرات را اسکرپ کنید

- اعلانات شغلی و صفحات کاری را اسکرپ کنید

این ابزار با دو حالت رایگان و پولی در اختیار شما قرار میگیرد. بسته به نیاز خود میتوانید طیف گستردهای از قابلیتها و دورهها را انتخاب کنید.

۳. Scrapy

این یک فریمورک عالی برای اسکرین اسکرپینگ و وب کراول است و برای کرال کردن در وبسایتها و استخراج دادههای ساختاریافته از صفحات آنها مورد استفاده قرار میگیرد. این فریمورک قابلیتهای دیگری نیز دارد، از استخراج داده گرفته تا نظارت و آزمایش خودکار.

همانطور که گفتم، پایتون به خاطر سهولت در یادگیری و استفاده شدن در Web scraping بسیار مشهور است. Scrapy تمام ابزارها، اطلاعات و نمونههای لازم را در اختیارتان قرار میدهد تا به شما کمک کند طی چند دقیقه شروع به کار کنید. برای این کار باید پایتون و اصول پایهای خط فرمان را یاد گرفته باشید.

۴. Apache Nutch™

عدم وجود رابط کاربری گرافیکی (GUI) در این ابزار سبب شده تا برای مبتدیان جذاب نباشد، اما ابزاری است که به طور گسترده برای کرال کردن در وب استفاده میشود. با کمک این ابزار در عرض چند ثانیه میتوانید به تعداد زیادی وبسایت دست پیدا کنید. این ابزار انعطافپذیر و قدرتمند است و در کنار سرور جستجوی Apache Solr ساخته شده میباشد.

Nutch متن باز است و برای موارد کرال کردن، رابطهای مدولار و قابل اتصال را فراهم میکند. میتوانید به راحتی موتور جستجوی خودتان را بسازید.

۵. Scrapinghub

این یک پلتفرم بسیار پیشرفته در زمینه کرال کردن با استفاده از "اسپایدرها" است. چنین پلتفرمی شما را قادر میسازد تا کرالرهای متعددی را به طور همزمان راهاندازی کنید. برای این کار شما نیازی به نظارت داشتن بر روی اتفاقات پس زمینه ندارید. شما تنها دادههای لازم را به آن میدهید و بقیه کارها را خودش به تنهایی انجام خواهد داد. همه چیز در دیتابیس Scrapinghub ذخیره میشود و به راحتی از API ما قابل بازیابی است.

من جدیدترین محصول متن باز آنها را خیلی دوست دارم. این محصول Portia نام دارد و به شما این امکان را میدهد تا خودتان به صورت سفارشی فرایند اسکرپینگ را انجام دهید. این محصول بیشتر به این خاطر ساخته شده تا شما با نحوه کار یک وب اسکرپر بصری آشنا شوید و بفهمید که چه دادههایی قابل بایگانی کردن و اسکرپینگ است.

۶. UBot Studio

میتوانید تمام کارهای آنلاین خود را با استفاده از Ubot Studio اتومات کنید. این به شما کمک میکند تا اطلاعات را جمعآوری کرده، دادهها را آنالیز کرده، اکانتهای آنلاین را همگامسازی کرده، دادهها را آپلود و دانلود کرده و همچنین تمام کارهایی که ممکن است در یک مرورگر وب انجام دهید را تکمیل کنید.

این ابزار توسط یکی از کاربران به من پیشنهاد شد، سپس تصمیم گرفتم آن را در لیست قرار دهم. در ابتدا تصور نمیکردم این ابزار بتواند در این لیست قرار بگیرد اما با کمی دقت متوجه شدم که UBot Studio یک پلتفرم کاملاً امیدوارکننده است که میتواند نحوه تعامل شما و تجارتتان را با کارهای روزمره در تکنولوژی وب تغییر دهد.

قابلیتهای UBot Studio با هر ارتقا افزایش پیدا میکند:

- میتوانید با استفاده از UBot شبکهای از وبلاگها را ساخته و آنها را به صورت خودکار مدیریت کنید

- به راحتی با یک کلیک اکانتهای خود را در محبوبترین شبکههای اجتماعی ایجاد کنید

- وبلاگها و شبکههای اجتماعی خود را به طور خودکار با یک پنجره آپدیت کنید

- میتوانید فیلمهای بسیاری را در محبوبترین سایتهای ویدیویی وب آپلود کنید

- انجام فعالیتهای پروژهشی که میتواند دیدگاهی جدید را در زمینه کلمات کلیدی ایجاد کند

- برای تمام نیازهای هاستینگ شما در پلتفرمهای معروفی مثل Blogger، WordPress و حتی cPanel کاربردی است.

قطعاً این ابزار اسکرپینگ با سایر ابزارهای موجود در لیست تفاوت دارد اما فکر میکنم با وجود قابلیتهای بسیار گستردهای که دارد، باید به این پلتفرم توجه بیشتری شود. متاسفانه استفاده از این ابزار رایگان نخواهد بود، اما اگر میخواهید پروژههای خود را با روشی کارآمد انجام دهید، پیشنهاد میکنم استفاده از این ابزار را مد نظر قرار دهید. در آخر این شما هستید که تصمیم میگیرید آیا این ابزار برای تجارت شما مفید بوده یا خیر.

برنامهها و ابزارهای کرال کردن در وب

در حال حاضر شما گزینههای انتخابی بسیاری را پیش روی خود دارید، بنابراین سعی کنید ابزاری مناسب را انتخاب کرده و از آن بهترین استفاده را داشته باشید. به نظر من با استفادهی درست از این ابزارها میتوان کارهای بسیار خوبی را انجام داد.

یک چیز معنادار پیدا کنید. چیزی که بتواند دیگران را تحت تاثیر قرار داده و آنها را وادار به امتحان کردن کند. کمترین نگرانی ما باید در مورد تواناییمان در استفاده از آنها باشد، زیرا در دنیا دورههای آموزشی بسیاری دربارهی بهترین شکل استفاده از این ابزارها وجود دارد.

امیدوارم چیزهای ارزشمندی را در اینجا پیدا کرده باشید. اگر از ابزارهای متفاوتی برای Web scraping استفاده میکنید، حتماً آنها را با ما به اشتراک بگذارید.

در حال دریافت نظرات از سرور، لطفا منتظر بمانید

در حال دریافت نظرات از سرور، لطفا منتظر بمانید